十、降維和度量學習

10.1、k-近鄰學習

10.1.1、懶惰學習

不關心學到什么,只一字不差的存儲內容

10.1.2、KNN錯誤率

最近鄰分離器的錯誤率:設樣本x,最近鄰z,錯誤率為1-(x和z同類)

X=z時,求得最近鄰分離器的泛化錯誤率<=2*最優貝葉斯分類器的泛化錯誤率。

最近鄰分類器雖簡單,但它的泛化錯誤率不超過貝葉斯最優分類器的錯誤率的兩倍!

10.2、低維嵌入

10.2.1、維數災難

在高維情形下出現的數據樣本稀疏、 距離計算困難等問題, 是所有機器學習方法共同面臨的嚴重障礙, 被稱為維數災難。

10.2.2、多維數縮放方法MDS

MDS (Multiple Dimensional Scaling) 旨在尋找一個低維子空間,

樣本在此子空間內的距離和樣本原有距離盡量保持不變

輸入:距離矩陣 \(\mathbf{D} \in \mathbb{R}^{m \times m}\), 其元素 \(d i s t_{i j}\) 為樣本 \(x_{i}\) 到 \(x_{j}\) 的距離; 低維空間維數d' :

過程:

1: 計算\({dist}_{i .}^{2}\),\({dist}_{. j}^{2}\),\({dist}_{. .}^{2}\)

2: 由此即可通過降維前后保持不變的距離矩陣 D 求取內積矩陣 B.

3: 對矩陣 B 做特征值分解;

\(B = V{\Lambda}V^T\)

其中 \({\Lambda} = diag(λ_1,λ_2, ...,{\lambda}_d)\)為特征值構成的對角矩陣,

4: 取 \(\tilde{\Lambda}\) 為 d' 個最大特征值所構成的對角矩陣,\(\tilde{V}\)為相應的特征向量矩陣.

輸出:矩陣\(\tilde{\mathbf{V}} \tilde{\mathbf{\Lambda}}^{1 / 2} \in \mathbb{R}^{m \times d^{\prime}}\),每行是一個樣本的低維坐標

10.3、PCA

https://blog.csdn.net/u010910642/article/details/51442939

10.3.1、最近重構性:樣本點到這個超平面的距離都足夠近

考慮整個訓練集,原樣本點\(x_i\)與基於投影重構的樣本點\(\hat{x_i}\)之間的距離為

\(\propto\)代表是正比

\(\boldsymbol{w}_{j}\) 是正交基 \(\sum_{i} \boldsymbol{x}_{i} \boldsymbol{x}_{i}^{\mathrm{T}}\) 是協方差矩陣,於是由最近重構性,有:

10.3.2、最大可分性:樣本點在這個超平面上的投影能盡可能分開

樣本點\(x_i\)在新空間上的投影為\(W^Tx_i\)

若所有樣本點能近可能分開,則應該使投影后樣本的方差最大,即\(\sum_ix_i^TWW^Tx_i\)

由\(x_i^TWW^Tx_i\)=\(tr(W^Tx_ix^T_iW)\)

可知優化目標函數為

10.3.3、求解

使用拉格朗日乘子法可得

\(XX^TW = {\lambda}W\)

只需對協方差矩陣 \(XX^T\) 進行特征值分解,並將求得的特征值排序\(:{\lambda}_1,{\lambda}_ 2 ··· {\lambda}_d\) ,再取前 d’ 個特征值對應的特征向量構成 \(W = (w_1, w_2, . . . , w_{d'} )\),這就是主成分分析的解。

10.4、流形學習

線性降維方法假設從高維空間到低維空間的函數映射是線性的,然而在許多現實任務中,可能需要非線性映射才能找到恰當的低維嵌入

10.4.1、核化PAC

核化PCA:加了一個核函數

假定 \(z_{i}\) 是由原始屬性空間中樣本點通過映射 \(\phi\) 產生, 即 \(_{\mathbf{z}_{i}}=\phi\left(\boldsymbol{x}_{i}\right), i=1,2, \ldots, m\)

於是有

令 \(\kappa\left(\boldsymbol{x}_{i}, \boldsymbol{x}_{j}\right)=\phi\left(\boldsymbol{x}_{i}\right)^{\mathrm{T}} \phi\left(\boldsymbol{x}_{j}\right)\) 可得 \(\mathbf{K A}=\lambda \mathbf{A}, \mathbf{A}=\left(\boldsymbol{\alpha}_{1} ; \boldsymbol{\alpha}_{\mathbf{2}} ; \ldots ; \boldsymbol{\alpha}_{\mathbf{m}}\right)\)

於是

10.4.2、ISOMAP

- 構造近鄰圖

- 基於最短路徑算法近似任意兩點之間的測地線(geodesic)距離

- 基於距離矩陣通過MDS獲得低維嵌入

10.4.3、LLE

-

為每個樣本構造近鄰集合\(Q_i\)

-

為每個樣本計算基於Qi的線性重構系數

\[\begin{aligned} \min _{\mathbf{w}_{1}, \mathbf{w}_{2}, \ldots, \mathbf{w}_{m}} & \sum_{i=1}^{m}\left\|\boldsymbol{x}_{i}-\sum_{j \in Q_{i}} w_{i j} \boldsymbol{x}_{j}\right\|_{2}^{2} \\ \text { s.t. } & \sum_{j \in Q_{i}} w_{i j}=1, \\ \end{aligned} \] -

在低維空間中保持\(w_{ij}\) 不變,求解下式

\[\\ \min _{\mathbf{z}_{1}, \mathbf{z}_{2}, \ldots, \mathbf{z}_{m}} \sum_{i=1}^{m}\left\|\boldsymbol{z}_{i}-\sum_{j \in Q_{i}} w_{i j} \boldsymbol{z}_{j}\right\|_{2}^{2} \]

10.5、度量學習

10.5.1、馬氏距離

馬氏距離就是特征空間通過矩陣L做完線性變換后的歐式距離。當L為單位陣時,馬氏距離就等於歐式距離。

其中 M 是一個半正定對稱矩陣,亦稱“度量矩陣”,距離度量學習就是要對 M 進行學習

十一、特征選擇和稀疏學習

11.1、子集搜索

用貪心策略選擇包含重要信息的特征子集

前向搜索:逐漸增加相關特征

后向搜索:從完整的特征集合開始,逐漸減少特征

雙向搜索:每一輪逐漸增加相關特征,同時減少無關特征

11.2、子集評價

其中信息熵定義為:

信息增益 Gain(A) 越大,意味着特征子集 A 包含的有助於分類的信息越多.於 是,對每個候選特征子集,我們可基於訓練數據集 D 來計算其信息增益,以此作為評價准則.

11.3、常見的特征選擇方法

11.3.1、Filter:過濾法

先對特征集進行特征選擇,然后再訓練學習器

特點:特征選擇過程與后續學習器無關,直接“過濾”特征

方法:對各個特征進行評分,設定閾值或者待選擇閾值的個數,來選擇特征。

11.3.1.1、Relief方法

針對二分類問題。

1、給定訓練集\({(x_1,y_1),(x_2,y_2)...(x_m,y_m,)}\)。

2、對每個示例,先在\(x_{i}\),的同類樣本中尋找其最近鄰\(x_{i,nh}\),稱為“猜中近鄰”(near-hit) 。

3、再從\(x_i\);的異類樣本中尋找最近鄰\(x_{i,nm}\),稱為“猜錯近鄰”(near-miss), 然后相關統計量。

4、在對應屬性j的分量為

\(\delta_{j}=\sum_{i}-\operatorname{diff}\left(x_{i}^{j}-x_{i, n h}^{j}\right)^{2}+\operatorname{diff}\left(x_{i}^{j}-x_{i, n m}^{j}\right)^{2}\)

5、其中\(x_{a}^j\),表示樣本\(x_{a}\)在屬性j上的取值。注意x。已經歸一化到[0,1]區間。

6、從上面的式子可以看出,若\(x_i\)與其猜中近鄰\(x_{i,nh}\)在屬性j上的距離小於與其猜錯近鄰\(x_{i,nm}\)的距離,則說明屬性j對區分同類與異類樣本是有益的,反之,則說明是無意義的。

11.3.1.2、其擴展變體Relief-F能處理多分類問題

\(\delta^{j}=\sum_{i}-\operatorname{diff}\left(x_{i}^{j}, x_{i, n h}^{j}\right)^{2}+\sum_{l \neq k}\left(p_{l} \times \operatorname{diff}\left(x_{i}^{j}, x_{i, l, n m}^{j}\right)^{2}\right)\)

\(p_l\)為第l類樣本在數據集D中所占的比例

11.3.2、包裹式

直接把最終將要使用的學習器的性能作為特征子集的評價准則,選擇的是“量身定做”的特征子集。

特點:多個特征聯合評價,對子集進行模型訓練和評價。

11.3.2.1、LVW

LVW(拉斯維加斯方法):隨機產生特征子集,使用交叉驗證來估計學習器的誤差,當在新特征子集上表現的誤差更小,或者誤差相當但包含的特征更少,就將新特征子集保留下來。

-

在循環的每一輪隨機產生一個特征子集

-

在隨機產生的特征子集上通過交叉驗證推斷當前特征子集的誤差

-

進行多次循環,在多個隨機產生的特征子集中選擇誤差最小的特征子集作為最終解*

-

若有運行時間限制,則該算法有可能給不出解

蒙特卡洛:在規定時間給出不符合要求的解。

11.3.3、嵌入式

特點:嵌入法將兩者融為一體,在同一個優化過程中完成,在學習訓練的過程中,自動進行了特征選擇。

方法:先使用某些機器學習的算法和模型進行訓練,得到各個特征的權值系數,根據系數從大到小選擇特征。

為了防止過擬合,會引入正則化項

考慮最簡單的線性回歸模型,以平方誤差為損失函數,並引入\(L_2\)范數正則化項防止過擬合,則有

11.3.3.1、嶺回歸 (ridge regression) [Tikhonov and Arsenin, 1977]

\(\min _{\boldsymbol{w}} \sum_{i=1}^{m}\left(y_{i}-\boldsymbol{w}^{\top} \boldsymbol{x}_{i}\right)^{2}+\lambda\|\boldsymbol{w}\|_{2}^{2}\)

11.3.3.2、將L2范數替換為L1范數,則有LASSO [Tibshirani, 1996]

易獲得稀疏解,是一種嵌入式特 征選擇方法

\(\min _{\boldsymbol{w}} \sum_{i=1}^{m}\left(y_{i}-\boldsymbol{w}^{\top} \boldsymbol{x}_{i}\right)^{2}+\lambda\|\boldsymbol{w}\|_{1}\)

11.4、使用范數正則化易獲得稀疏解

L1正則化的解具有稀疏性,可用於特征選擇。

L1正則化方法:近端梯度下降。

L2正則化的解都比較小,抗擾動能力強。

從貝葉斯的角度,L2相當於給θ一個先驗分布為高斯分布

11.5、稀疏表示

稀疏表示:特征—>矩陣,矩陣->稀疏矩陣

文本數據線性可分l 存儲高效

普通稠密表達的樣本找到合適的字典,將樣本轉化為稀疏表示,這一過程稱為字典學習。

壓縮感知:利用部分數據恢復全部數據。

𝐴具有“限定等距性”時,可以近乎完美地恢復𝒔

11.6、矩陣補全

NP難問題. 將rank(𝐗)轉化為其凸包“核范數”(nuclear norm)

凸優化問題,通過半正定規划求解(SDP,Semi-Definite

十二、半監督學習

12.1、高斯混合模型(Gaussian Mixture Model)通常簡稱GMM

1、通過觀察采樣的概率值和模型概率值的接近程度,來判斷一個模型是否擬合良好。

2、然后我們通過調整模型以讓新模型更適配采樣的概率值。反復迭代這個過程很多次,直到兩個概率值非常接近時,我們停止更新並完成模型訓練。

3、我們要將這個過程用算法來實現,所使用的方法是模型生成的數據來決定似然值,即通過模型來計算數據的期望值。

4、通過更新參數μ和σ來讓期望值最大化。

5、這個過程可以不斷迭代直到兩次迭代中生成的參數變化非常小為止。

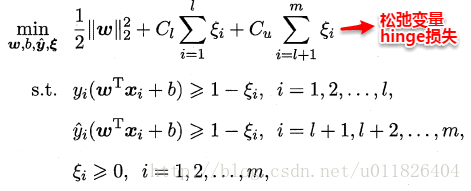

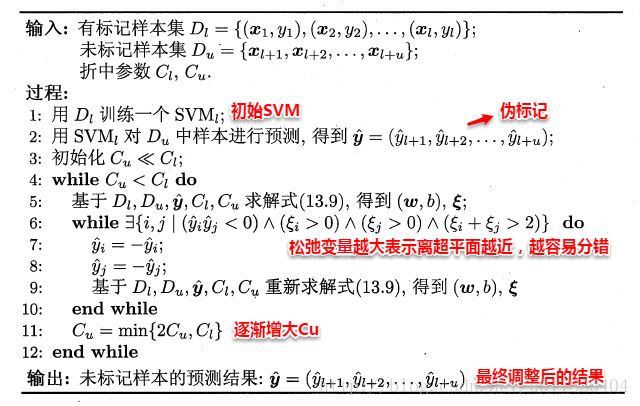

12.2、TSVM

https://blog.csdn.net/u011826404/article/details/74358913

監督學習中的SVM試圖找到一個划分超平面,使得兩側支持向量之間的間隔最大,即“最大划分間隔”思想。對於半監督學習,S3VM則考慮超平面需穿過數據低密度的區域。TSVM是半監督支持向量機中的最著名代表,其核心思想是:嘗試為未標記樣本找到合適的標記指派,使得超平面划分后的間隔最大化。TSVM采用局部搜索的策略來進行迭代求解,即首先使用有標記樣本集訓練出一個初始SVM,接着使用該學習器對未標記樣本進行打標,這樣所有樣本都有了標記,並基於這些有標記的樣本重新訓練SVM,之后再尋找易出錯樣本不斷調整。整個算法流程如下所示:

類別不平衡問題:

\(C_u^+=\frac{u_-}{u_+}C_u^-\)

開銷巨大

12.3、圖半監督學習

12.4、基於分歧

兩個“充分”(sufficient)且“條件獨立”視圖。

兩個learner分別給無標記數據生成一個偽標簽喂給另一個learner,進行訓練。

僅需弱學習器之間具有顯著的分歧(或差異), 即可通過相互提供偽標記樣本的方式來提高泛化性能。

特點:

-

只需采用合適的基學習器,學習方法簡單有效、理論基礎相對堅實、適用范圍較為廣泛。

-

需能生成具有顯著分歧、性能尚可的多個學習器,

-

但當有標記樣本很少、尤其是數據不具有多視圖時, 要做到這一點並不容易。

12.5、半監督聚類

基於無監督,有標記樣本提供額外的監督信息。

-

勿連和必連:約束k均值。選擇最近簇時出錯不滿足要求則選擇次近簇。約束k均值算法。

- 該算法是k均值算法的擴展,它在聚類過程中要確保“必連 ”關系集合與“勿連”關系集合中的約束得以滿足,否則將返回錯誤提示。

-

類標:第二種監督信息是少量有標記樣本。即假設少量有標記樣本屬於k個聚類簇。

- 約束種子k均值。作為聚類種子初始化,更新簇時不計算,計算簇中心計算,

十三、概率圖模型:基本概念和方法

13.1、隱馬爾可夫模型(動態貝葉斯網)

13.2、馬爾可夫隨機場

13.3、條件隨機場

條件隨機場是一種判別式 無向圖模型(可看作給定觀測值的MRF)

條件隨機場對多個變量 給定相應觀測值后的條件概率進行建模,若令\(x= x_1,x_2,...,x_n\)為觀測序列,\(y= y_1,y_2,...,y_n\)為對應的標記序列, CRF的目標是構 建條件概率模型\(P(y|x)\)。

13.4、學習與推斷

13.4.1、精確推斷

13.4.2、信念傳播

13.4.3、近似推斷

采樣法(sampling):通過使用隨機化方法完成

在很多任務中,我們關心某些概率分布並非因為對這些概率分布本身感興趣,而是要基於它們計算某比期望,並且還可能進一步基於這些期望做出決策.

采樣法正是基於這個思路.具體來說,假定我們的目標是計算函數 f(x) 在 概率密度函數 p(x) 下的期望

則可根據 p(x) 抽取一組樣本 \(\left\{x_{1}, x_{2}, \ldots, x_{N}\right\}\), 然后計算 f(x) 在這些樣本上的均值

13.4.3.1、MCMC采樣

馬爾可夫鏈蒙特卡羅 (Markov Chain Monte Carlo,簡稱 MCMC)方法:

給定連續變量 \(x\in X\)的概率密度函數 p(x),x在區間 A 中的概率可計算為

若有函數 \(f: X \mapsto \mathbb{R}\), 則可計算 \(f(x)\) 的期望

若𝑥為高維多元 變量且服從一個復雜分布,積分操作會很困難。

p MCMC先構造出服從𝒑分布的獨立同分布隨機變量\(\mathbf{X}_{1}, \mathbf{X}_{2}, \ldots, \mathbf{X}_{\mathbf{N}}\),再得到無偏估計

13.4.3.2、MH算法

13.4.4、變分推斷

13.5、話題模型

十四、強化學習簡介

14.1、MDP

1、機器處於環境 \(E\) 中, 狀態空間為 \(X\), 其中每個狀態 \(x \in X\) 是機器感知到的環境的描述,

2、如在種瓜任務 上這就是當前瓜苗長勢的描述; 機器能采取的動作構成了動作空間 \(A\), 如種瓜過程中有澆水、施不同的肥、使用不同的農葯等多種可供選擇的動作;

3、若某個 動作 \(a \in A\) 作用在當前狀態 \(x\) 上, 則潛在的轉移函數 \(P\) 將使得環境從當前狀態 按某種概率轉移到另一個狀態, 如瓜苗狀態為缺水, 若選擇動作澆水, 則瓜苗長勢會發生變化, 瓜苗有一定的概率恢復健康, 也有一定的概率無法恢復;

4、在轉移 到另一個狀態的同時, 環境會根據潛在的“獎賞” \((\mathrm{reward})\) 函數 \(R\) 給機器獎賞,如保持瓜苗健康對應獎賞 \(+1\), 瓜苗調零對應獎賞 \(-10\), 最終種出了 好瓜對應獎賞 \(+100 .\)

5、綜合起來, 強化學習任務對應了四元組 \(E=\langle X, A, P, R\rangle\), 其中 \(P: X \times A \times X \mapsto \mathbb{R}\) 指定了狀態轉移概率, \(R: X \times A \times X \mapsto \mathbb{R}\) 指定了獎賞;

6、在有的應用中, 獎賞函數可能僅與狀態轉移有關, 即 \(R: X \times X \mapsto \mathbb{R} .\)

圖 \(16.2\) 給出了一個簡單例子:給西瓜澆水的馬爾可夫決策過程。

1、該任務中只有四個狀態(健康、缺水、溢水、凋亡)和兩個動作(澆水、不澆水)

2、在每一步轉移后,若狀態是保持瓜商健康則獲得獎賞 1,瓜苗缺水或溢水獎賞為-1,這時通過澆水或不澆水可以恢復健康狀態,當瓜苗凋亡時獎賞是最小值 -100且無法恢復.

3、圈中箭頭表示狀態轉移,箭頭旁的 α,p,r 分別表示導致狀態轉移的動作、轉移概率以及返回的獎賞.

4、容易看出,最優策略在"健康"狀態選擇動 作"澆水"、在"溢水"狀態選擇動作"不澆水"、在"缺水"狀態選擇動 作"澆水"、在"調亡"狀態可選擇任意動作.

1、機器要做的是通過在環境中不斷地嘗試而學得一個 “策略”(policy) \(\pi\)

2、根據這個策略, 在狀態 \(x\) 下就能得知要執行的動作 \(a=\pi(x)\), 例如看到瓜苗狀態是缺水時,能返回動作“澆水".

3、策略有兩種表示方法: 一種是將策略表示為函數 \(\pi: X \mapsto A\), 確定性策略常用這種表示。

4、另一種是概率表示 \(\pi: X \times A \mapsto \mathbb{R}\), 隨機性策略常用這種表示。

5、\(\pi(x, a)\) 為狀態 \(x\) 下選擇動作 \(a\) 的概率, 這里必須有 \(\sum_{a} \pi(x, a)=1\)。

6、策略的優劣取決於長期執行這一策略后得到的累積獎賞,例如某個策略使 得瓜苗枯死, 它的累積獎賞會很小, 另一個策略種出了好瓜, 它的累積獎賞會很大.

7、在強化學習任務中, 學習的目的就是要找到能使長期累積獎賞最大化的策 略. 長期累積獎賞有多種計算方式

8、常用的有“ \(T\) 步累積獎賞” \(\mathbb{E}\left[\frac{1}{T} \sum_{t=1}^{T} r_{t}\right]\) 和“ \(\gamma\) 折扣累積獎賞" \(\mathbb{E}\left[\sum_{t=0}^{+\infty} \gamma^{t} r_{t+1}\right]\), 其中 \(r_{t}\) 表示第 \(t\) 步獲得的獎賞值, \(\mathbb{E}\) 表 示對所有隨機變量求期望.