https://www-file.huawei.com/-/media/corporate/pdf/cyber-security/ai-security-white-paper-cn.pdf

HW AI安全白皮書

谷歌可解釋人工智能白皮書,27頁pdf,Google AI Explainability Whitepaper

【導讀】近幾年,隨着人工智能的迅速發展,人工智能對各行各業也產生了深遠的影響。圍繞人工智能建立的系統已經對醫療、交通、刑事司法、金融風險管理和社會的許多其他領域產生了巨大的價值。然而,人工智能系統仍然具有很多問題,為了保證人工智能系統的有效性和公平性,需要我們對人工智能具有深刻的理解和控制能力。所以,今天專知小編給大家帶來的是Google可解釋人工智能白皮書《AI Explainability Whitepaper》,總共27頁pdf,主要介紹谷歌的AI平台上的AI的可解釋性。

機器學習發展

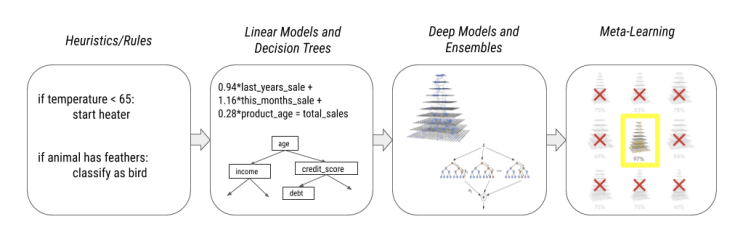

人工智能的迅速發展導致現在我們現在所研究和使用的AI模型越來越復雜化,從手工規則和啟發法到線性模型和決策樹再到集成和深度模型,最后再到最近的元學習模型。

這些變化已經導致了多個維度上規范的變化:

-

可表達性(Expressiveness),使我們能夠在越來越多的領域(如預測、排名、自主駕駛、粒子物理、葯物發現等)擬合各種各樣的功能。

-

通用性(Versatility),解鎖數據模式(圖像,音頻,語音,文本,表格,時間序列等),並啟用聯合/多模式應用。

-

適應性(Adaptability ),通過遷移學習和多任務學習來適應小數據狀態。

-

效率(Efficiency ),通過自定義優化硬件,如gpu和TPUs,使研究人員可以更快地訓練更大更復雜更強大的模型。

然而,這些更復雜更強大的模型也變得越來越不透明,再加上這些模型基本上仍然是圍繞相關性和關聯建立的,這導致了以下幾個挑戰和問題:

-

虛假的關聯性(Spurious correlations),這往往會妨礙模型的泛化能力,導致模型在現實場景下效果很差。

-

模型的調試性和透明性的缺失(Loss of debuggability and transparency),這會導致模型難以調試和改進,同時這種透明度的缺乏阻礙了這些模型的應用,尤其是在受到監管的行業,如銀行和金融或醫療保健行業。

-

代理目標(Proxy objectives),這會導致模型在線下的效果與實際場景下的效果存在很大的出入。

-

模型的不可控(Loss of control)

-

不受歡迎的數據放大(Undesirable data amplification)

AI方法有:

-

簡單(基於規則且可解釋)

-

復雜的(不是可解釋的)

根據應用不同,我們有明確的倫理、法律和商業理由來確保我們能夠解釋人工智能算法和模型如何工作。不幸的是,普通人可以解釋的簡單人工智能方法缺乏優化人工智能決策的准確性。許多提供最佳精度的方法,如ANN(人工神經網絡),都是復雜的模型,其設計並不是為了便於解釋。

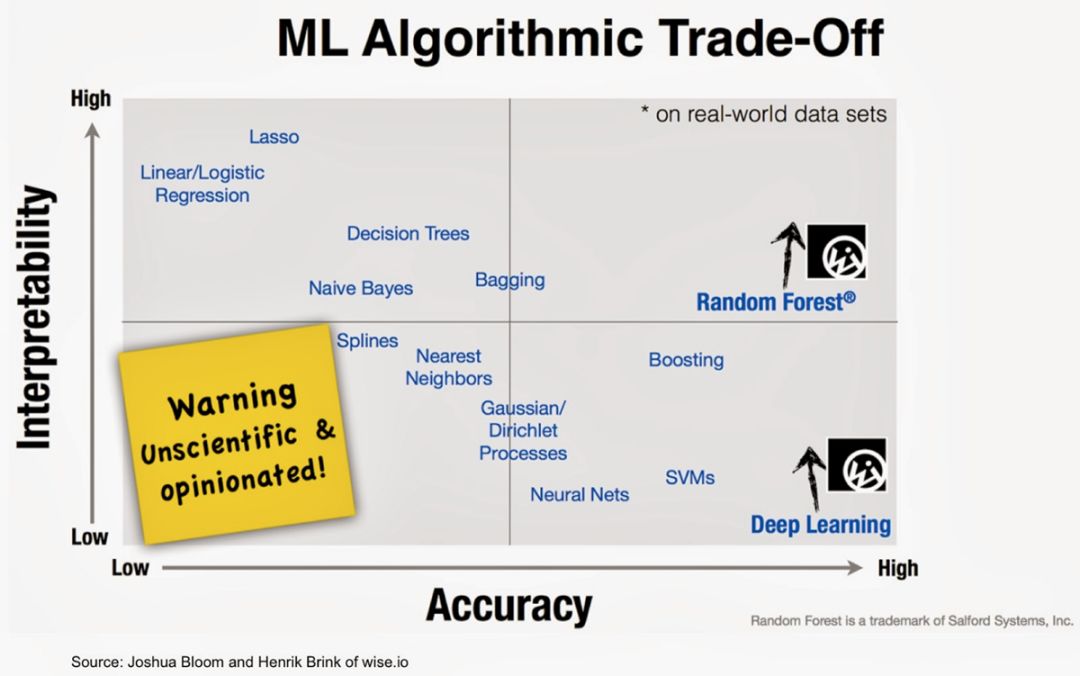

如圖所示,人工智能方法的准確性和可解釋性之間存在着一種相反的關系。兩者之間的負相關關系如下: 解釋性越大,准確性越低,反之亦然。

一些不太精確的模型仍然很受歡迎,因為它們具有可模擬性(因此人類可以重復它們)、完全可解釋的計算過程(算法透明性)以及模型的每個部分都有一個直觀的解釋(可分解性)。

隨着深度學習和強化學習的普及,對復雜神經網絡的解釋需求激增,推動了XAI工具的發展。最終目標: 實現負責任的、可追溯的、可理解的AIs。

可解釋人工智能 XAI

這些挑戰突出了對人工智能的可解釋性的需求,以使人們可控的發展人工智能。

圍繞人工智能建立的系統將影響並在許多情況下重新定義醫療干預、自動交通、刑事司法、金融風險管理和社會的許多其他領域。然而,考慮到上一節所強調的挑戰,這些人工智能系統的有效性和公平性將取決於我們理解、解釋和控制它們的能力。

自從幾十年前專家系統出現以來,XAI(可解釋的AI)領域已經復蘇。本文對一種嚴謹的科學解釋的機器學習,Doshi-Velez和Kim定義為“解釋性或呈現在人類可以理解的術語的能力“利用韋氏字典的定義“解釋”,它適應人類和智能代理之間的交互。

谷歌的人工智能可解釋白皮書(AI Explainability Whitepaper)是谷歌雲的人工智能解釋產品的技術參考。它的目標用戶是負責設計和交付ML模型的模型開發人員和數據科學家。谷歌雲的可解釋產品的目標是讓他們利用對AI解釋性來簡化模型開發,並解釋模型的行為。

白皮書的目錄:

-

特征歸因(Feature Attributions)

-

特征歸因的限制和使用注意事項(Attribution Limitations and Usage Considerations)

-

解釋模型元數據(Explanation Model Metadata)

-

使用What-if工具的可視化(Visualizations with the What-If Tool)

-

使用范例(Usage Examples)

參考鏈接:

https://cloud.google.com/ml-engine/docs/ai-explanations/overview

人工智能的下一個挑戰 —— 可解釋性和可詮釋性?

作者: Sashi Obilisetty, 新思科技 R&D 總監

“It’s not a human move. I’ve never seen a human play this move(這不是人類的下棋策略。我從來沒見過任何人這樣下棋。)”

2016年,谷歌AlphaGo挑戰世界上最偉大的圍棋選手之一,李世石,當AlphaGo最終擊敗世石,取得決定性勝利時,另一位圍棋專家樊麾如此評論道。

樊麾的這句經典點評,恰恰反映了我們正在使用超精確的機器學習(ML)模型時所面臨的問題。盡管這些模型展示了超越人類的能力,但我們尚不確定輸入的數據中的哪些具體信息,使它們做出決定。深度學習模型通常包含深度嵌套的非線性結構,使其變得不那么透明。缺乏透明度, 對AlphaGo本身來說不是問題。然而,在可解釋性(explainability)、可詮釋性(interpretability)和透明度至關重要的領域(如醫療診斷、軍事和戰斗行動)中,模型的不透明性則大大阻礙了AI/ML的擴展。

在人工智能和機器學習中,可解釋性(explainability)和可詮釋性(interpretability)經常互換使用。然而,這兩者之間有一個細微的區別。可解釋性是關於理解為什么某些事情發生的機制,而可詮釋性是關於如何用人類的術語很好地來說明白這些機制。可詮釋性的研究目前發展迅速;但有很多還需要做。

ML模型中精確度和可解釋性之間的權衡,神經網絡是最缺乏解釋性的。

解決方案:

上圖所示,經典的機器學習算法(如線性算法或基於樹的算法)的可詮釋性很好。而現有的模型不可知方法可分為5大類:

- 可視化(Visualizations): 提高模型可詮釋性的常用可視化方法有:部分依賴圖(Partial Dependenc Https://Christophm.Github.Io/Interpretable-Ml-Book/e Plots, PDP)、個體條件期望圖(Individual Conditional Expectation , ICE)和累積局部效應圖(Accumulated Local Effects , ALE)PDP和ICE可以用來顯示特征對預測值的影響,特別是當關系是線性的、單調的(特征對目標的影響總是在同一方向,但不以恆定的速度)或更復雜的情況下。當特征互相關聯時,ALE圖則更有用(在這種情況下,PDPs不是很有用)。

- 基於特性的(Feature-based): 特征的交互和特征重要性也是了解模型的方法。H值 (H-statistic, 由Friedman提出的一種度量方法)是一種廣泛應用於特征交互的度量方法。特征重要性的概念相當簡單。特征的重要性是通過對特征值進行變更后,預測誤差的增加來衡量的。若預測誤差沒有變化,說明該特性“不重要”。

- 代理模型:代理模型在許多工程領域都很常見。代理建模背后的概念是,如果測量輸出值耗時且麻煩,我們可以使用更快的代理模型。在機器學習中,代理模型需是可詮釋的機器學習模型。

Shapley Values(Shapley Values): Shapley技術博弈論(game theory)為基礎。博弈論中的一個經典問題是,倘若玩家擁有不同的技能水平,他們將如何為總支出做出貢獻。在機器學習中,支出是對單個實例的預測,而特征就是不同的玩家。非常坦白地說,個人認為Shapley值對於計算任何ML模型(不僅僅是線性模型)中特征對單個預測的貢獻特別有用。 - LIME: LIME(Local interpretable model-agnostic explanations的縮寫,局部保真可詮釋的與模型無關的解釋)背后的關鍵想法是,通過一個簡單的本地模型來近似一個黑盒子模型,要比試圖全局近似一個模型容易得多。LIME將模型視為一個黑盒子,對於每個感興趣的實例,生成一個新的數據集,該數據集由變更后的樣本和黑盒子模型的相應預測組成。這個經過更改的數據集構成了可詮釋模型的基礎,該模型通過采樣的實例與目標實例之間的接近程度來加權。

然而,不是每一個上述方法都能對深度神經網絡管用。

在今后, 我會討論其他方法來提高卷積神經網絡(CNN)和 循環神經網絡(RNN)的詮釋性。